Clean-Param in der robots.txt bei Blogger – SEO-Leitfaden

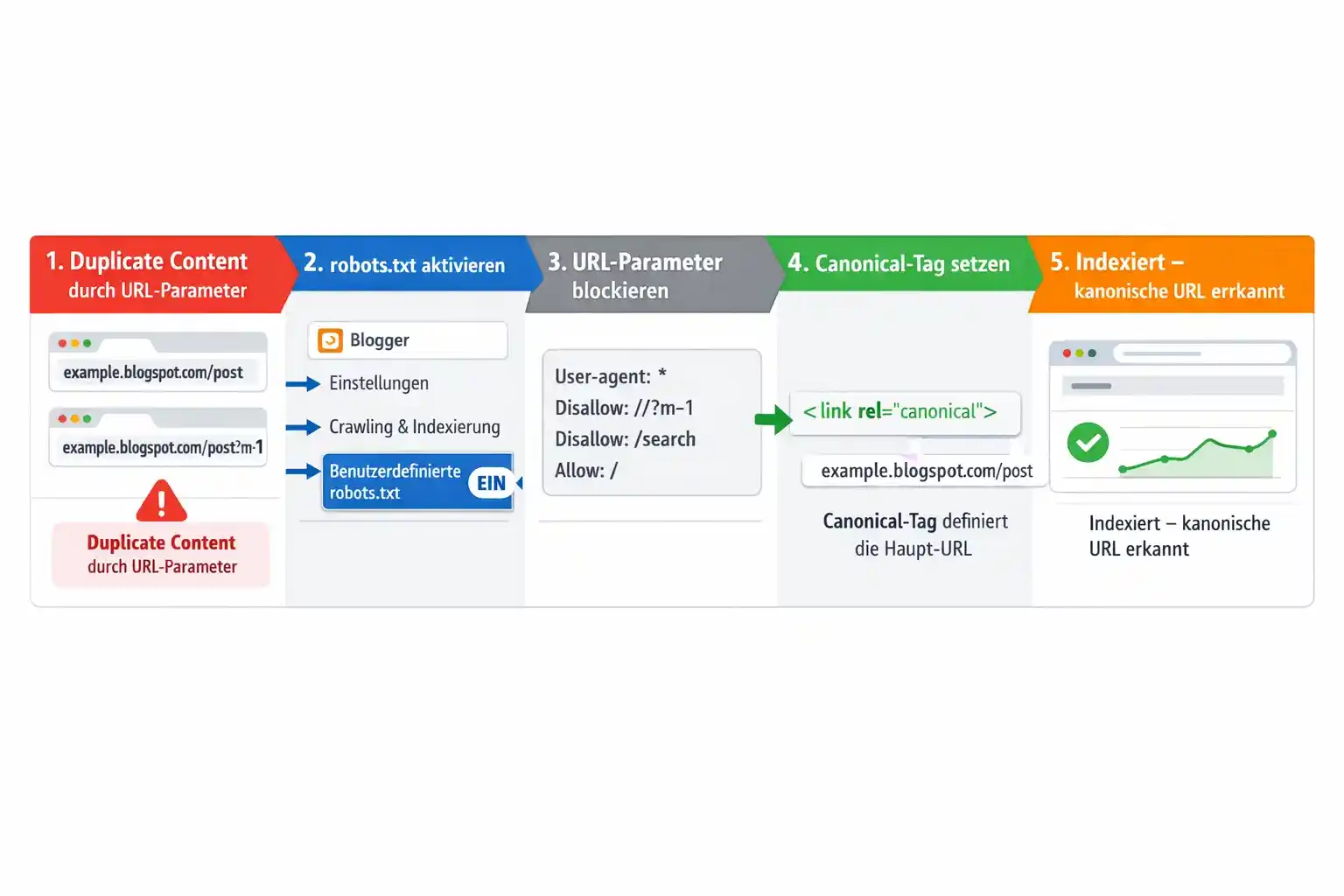

Viele Blogger-Websites verlieren Rankings durch

Duplicate Content. Ursache sind URL-Parameter wie

?m=1 oder interne Suchseiten, die identische Inhalte unter

verschiedenen URLs erzeugen.

Schritt 1: Duplicate Content durch URL-Parameter erkennen

Viele URLs mit Parametern wie ?m=1 erzeugen Duplicate Content.

Suchmaschinen können Signale der doppelten Seiten nicht korrekt zusammenführen.

Schritt 2: Benutzerdefinierte robots.txt aktivieren

Die robots.txt steuert nur das Crawling, nicht unbedingt die Indexierung.

Sie hilft, unnötige Parameter-URLs zu begrenzen.

Schritt 3: URL-Parameter in robots.txt blockieren

User-agent: *

Disallow: /*?m=1

Disallow: /search

Allow: /

Sitemap: https://yourblog.blogspot.com/sitemap.xml

Schritt 4: Canonical-Tag setzen & Googlebot-Mobile prüfen

<link expr:href='data:blog.url.canonical' rel='canonical'/>

Trotz korrekt gesetztem Canonical-Tag können Warnungen in der Google Search Console erscheinen.

Speziell Googlebot-Mobile erkennt manchmal URLs mit Parametern wie ?m=1,

verhindert jedoch nicht immer die Indexierung dieser Seiten.

Die beste Vorgehensweise: Stellen Sie sicher, dass jede Seite eine eindeutige kanonische URL hat.

Fügen Sie das canonical-Tag innerhalb des <head> Ihres Blogger-Templates ein.

Dadurch erkennt Google die Hauptversion der Seite und ignoriert Duplikate.

<link expr:href='data:blog.url.canonical' rel='canonical'/>

Schritt 4a: Umgang mit Drittanbieter-Templates

- Prüfen Sie, ob das Template ein

canonical-Tag enthält. - Regelmäßige Überprüfung der Links mit Tools für Webmaster.

- Bei Bedarf: Template anpassen oder auf offizielles Template wechseln, um SEO-Konformität sicherzustellen.

Schritt 4b: Statusüberwachung via Webmaster-Tools

Nutzen Sie Google Search Console

und Yandex Webmaster

um doppelte Inhalte und Indexierungsprobleme zu überwachen. Fehlende Beachtung von URL-Parametern kann insbesondere bei Yandex die Qualitätsbewertung Ihrer Website negativ beeinflussen.

Schritt 5: Indexierung in Google Search Console prüfen

Fazit

- Clean-Param ist bei Blogger nicht nutzbar

- robots.txt steuert Crawling, nicht Indexierung

- Canonical-Tags sind entscheidend für SEO

- SVG-Grafiken verbessern UX & Verständlichkeit